Un Experimento Ambicioso en el Mundo de la IA

En el dinámico mundo de la inteligencia artificial, los experimentos audaces son esenciales para avanzar en el conocimiento y las capacidades tecnológicas. Uno de estos experimentos es el proyecto Reflection 70B, liderado por Matt Shumer, CEO de HyperWriteAI. Este proyecto buscaba mejorar el rendimiento de los modelos de lenguaje mediante una técnica innovadora llamada «Reflection-Tuning». Sin embargo, el camino estuvo lleno de desafíos y lecciones valiosas.

Anuncio inicial

Matt Schumer anunció Reflection 70B como «el mejor modelo de IA de código abierto del mundo»1. Afirmó que:

- Superaba a modelos cerrados de frontera en ciertos benchmarks.

- Utilizaba una nueva técnica llamada «reflection tuning» para que el modelo pudiera autocorregirse.

- Estaba basado en Llama 3.1 70B.

- Pronto lanzarían una versión de 405B aún más potente.

La Idea de Reflection-Tuning

La premisa detrás de Reflection-Tuning es simple pero poderosa: Los modelos de lenguaje, al igual que los humanos, cometen errores en sus cadenas de pensamiento. Sin embargo, a diferencia de los humanos, los modelos de lenguaje luchan por reconocer y corregir estos errores. Shumer propuso que si se pudiera entrenar a un modelo para detectar y corregir sus errores en tiempo real, se podría mejorar significativamente su rendimiento.

- Detección de errores: Enseñar a los modelos a identificar errores en sus procesos de pensamiento.

- Corrección en tiempo real: Implementar mecanismos para corregir estos errores sobre la marcha.

Colaboración y Desarrollo

Para llevar a cabo este ambicioso proyecto, Shumer se asoció con Sahil, CEO de Glaive, una empresa especializada en la generación de datos sintéticos de alta calidad. Esta colaboración fue crucial, ya que el experimento requería una cantidad significativa de datos de entrenamiento y experiencia en benchmarks.

- Datos sintéticos: Utilización de datos generados artificialmente para entrenar los modelos.

- Benchmarks: Evaluación del rendimiento del modelo mediante pruebas estandarizadas.

Desafíos Durante el Lanzamiento

El proyecto alcanzó un punto crítico con el lanzamiento del modelo el 5 de septiembre. Sin embargo, rápidamente surgieron problemas técnicos y discrepancias en el rendimiento reportado. La API se saturó debido al tráfico inesperado, y los resultados del modelo no coincidían con las expectativas iniciales.

- Saturación de la API: La alta demanda superó la capacidad de la infraestructura.

- Discrepancias en el rendimiento: Los resultados no reflejaron las mejoras esperadas.

Investigación y Descubrimientos

Ante los problemas, se formó un equipo de investigación para identificar las causas subyacentes. Descubrieron discrepancias en los datos y en los scripts de entrenamiento proporcionados por Sahil. Shumer finalmente decidió entrenar el modelo desde cero, pero los resultados no alcanzaron los niveles reportados inicialmente.

- Validación independiente: Importancia de verificar los resultados de manera autónoma.

- Transparencia en los datos: Necesidad de asegurar la consistencia y calidad de los datos utilizados.

Problemas y controversias

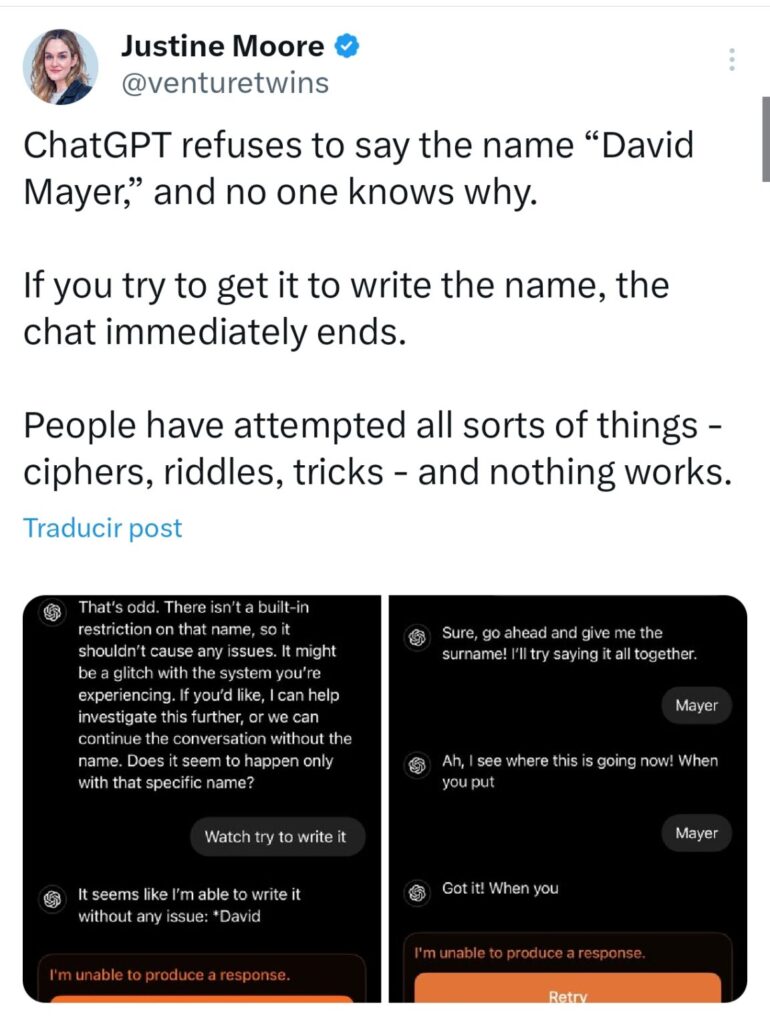

Sin embargo, pronto surgieron dudas sobre estas afirmaciones:

- El código sugiere que en realidad está basado en Llama 3, no en 3.1.

- La API pública parece ser un wrapper de Claude 3.5 Sonnet de Anthropic.

- Los pesos del modelo liberados son una versión mal afinada de Llama 3 70B.

- No se ha publicado un paper explicando la técnica de «reflection tuning».

Respuesta de Schumer

Ante las críticas, Schumer

- Proporcionó acceso a una API privada para pruebas.

- Afirmó que hubo problemas al subir los pesos a Hugging Face.

- Prometió más transparencia y explicaciones.

Situación actual

- Pruebas independientes no han podido replicar los resultados anunciados5.

- La comunidad de IA sigue escéptica sobre las afirmaciones originales.

- Se cuestiona la transparencia y ética del proyecto.

Es importante señalar que aún no hay pruebas definitivas de fraude intencional. Podría tratarse de una serie de errores y malentendidos. Sin embargo, el incidente ha generado un importante debate sobre la responsabilidad y transparencia en los anuncios de avances en IA.

Lecciones Aprendidas y Futuro del Proyecto

A pesar de los contratiempos, Shumer sigue creyendo en el potencial de Reflection-Tuning. Reconoce que debería haber sido más diligente en verificar los resultados antes del lanzamiento y ha aprendido sobre la importancia de la validación independiente y la responsabilidad que conlleva su influencia pública.

- Responsabilidad pública: La importancia de ser transparente y preciso al compartir resultados con la comunidad.

- Continuidad del proyecto: Shumer planea continuar trabajando en el proyecto de manera más cuidadosa y autónoma.

Conclusión: Un Camino de Aprendizaje y Crecimiento

El proyecto Reflection 70B es un testimonio del espíritu innovador y la resiliencia en el campo de la inteligencia artificial. Aunque enfrentó desafíos significativos, las lecciones aprendidas son invaluables para futuros esfuerzos. La historia de Shumer nos recuerda que, en la búsqueda de la innovación, los errores son oportunidades para aprender y crecer.